利用 SSD 卸载技术扩展 AI 规模

内存使用量减少 57%,查询速度提高 50%? 这怎么可能?

搭载检索增强生成 (RAG) 的 AI 推理正迎来“伍德斯托克时刻”。

1969 年那场传奇音乐节的主办方原预计观众约为 5 万人。但由于演出阵容实在逆天,吉米·亨德里克斯 (Jimi Hendrix)、詹尼斯·乔普林 (Janis Joplin)、谁人乐队 (The Who) 以及其他数十位巨星齐聚,加之反文化浪潮恰逢其时,最终这场在纽约州贝瑟尔奶牛农场举办的音乐节,吸引了近 50 万人蜂拥而至。结果,对多数亲历者而言,食物短缺、卫生困境与泥泞场地远比音乐本身更令人难忘。

同样地,采用 RAG 的推理技术以其强大魅力成为解决商业问题的绝佳方案,引发企业争先恐后的采用热潮。当然,问题在于,若缺乏完善的基础设施,这项技术的潜力就会因体验不佳或完全无法使用而无法释放。

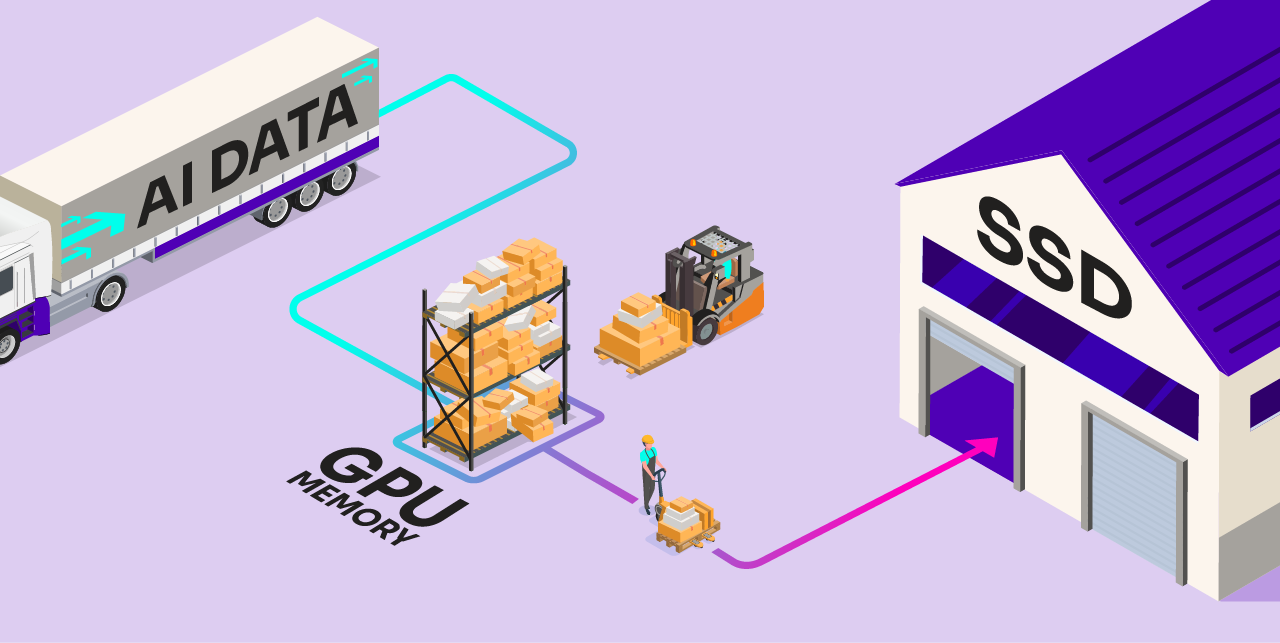

我们需要一种全新的解决方案——能够实现前所未有的扩展能力与成本效益的方案。我们很高兴地与大家分享 Solidigm 和 Metrum AI 的突破性工作成果。我们在此概述的策略可将 AI 模型权重和 RAG 数据等海量数据从昂贵的内存卸载到高性能 SSD,以前所未有的方式释放 AI 潜能。

Metrum AI 首席执行官 Steen Graham 表示:“我们开发了突破性的视频分析 RAG 解决方案,通过整合最先进的视觉语言模型与大语言模型,可生成丰富的场景化摘要。该方案部署在 Solidigm D7-PS1010 SSD 中,并集成 DiskANN 技术实现高速、低内存占用的矢量搜索,在保证性能的同时显著优化内存使用效率。”

阅读下文,了解我们的创新方法与关键发现。您也可以下载完整的白皮书《具有 SSD 卸载功能的高性能 TCO 优化 RAG》(High-Performance TCO-Optimized RAG With SSD Offloading),对于“实践派”读者,我们已经在 GitHub repo 中提供了全部内容,欢迎亲身体验!

RAG 是什么?它为何如此火爆?

举个简单的例子:想象一下,您向 AI 聊天机器人询问前往国外旅行需要哪些文件。如果模型的训练数据集中包含充分且准确的信息,它便能给出实用答案。

否则,可能会出现两种情况。它可能回答“不知道”,更糟的是,还可能自信满满地给出错误答案。这种现象被称为“幻觉回答”,其发生频率远超常人想象。

显然,AI 的价值与模型可用数据的数量和质量息息相关。

顾名思义,检索-增强生成技术会在生成回复之前,检索额外的相关数据,以扩展模型的知识。该技术通过将模型连接至原始训练集之外的数据源来实现这一目标。这些数据源可以是企业内部数据库、实时新闻流,甚至是维基百科,几乎涵盖所有类型的数据来源。因此,在用户旅行咨询的案例中,系统会将查询请求发送至一个或多个此类数据源,先抓取相关信息再交由 AI 模型处理,从而显著提升获得优质回复的概率。

RAG 技术的优势具有双重性

- 企业无需不断重新训练模型即可扩展数据覆盖范围。

- 该技术使模型能够调用比公共训练集更及时、权威且精准的信息。

随着支持超长上下文窗口的新模型涌现,关于“RAG 是否已经消亡”的争论正愈演愈烈。以 Meta 的 Llama 4 Scout 为例,其上下文窗口可容纳 1,000 万个 Token。有人认为,如果能在提示词中输入这么多数据,则无需连接外部数据源;只需将所有相关信息直接嵌入提示词即可。

从表面上看,这种说法不无道理,但可能为时过早。2025 年 3 月的一项研究论文测试了这些超长上下文窗口新模型的召回率(准确度),发现即使模型表面上支持数百万 Token 上下文窗口,实际使用时超过约 2,000 就会导致召回率下降。

那么问题是?

由此可见,企业纷纷支持 RAG 的推理技术实属必然。这正与 50 多年前伍德斯托克音乐节主办方面临的困境如出一辙。越来越多的用户突然提出了更高的要求。

具体来说,企业希望:

- 扩展 RAG 数据集规模,提升 AI 模型可获取数据的数量与质量

- 采用更复杂的模型来处理数据并生成高质量的洞察

这两个目标都极具价值。但二者均涉及海量数据存储这一核心挑战。在当今技术实践中,模型权重与 RAG 数据通常存储于内存,但这种方案很快就会导致成本急剧攀升。

SSD 卸载方案应运而生

Solidigm 与 Metrum AI 携手开创了全新的技术路径。我们的方案基于开源软件组件的精心遴选与调优,使其协同运作,在 AI 推理过程中将海量数据从内存智能迁移至 SSD。

有两个关键组成部分:

- RAG 数据卸载:借助 DiskANN(一套针对大规模矢量数据搜索的算法工具),我们可以将部分 RAG 数据集迁移至 SSD 存储中。这样做的主要好处是能够以更高的成本效益扩展至更庞大的数据集。

- 模型权重卸载:利用 Ray Serve 和 DeepSpeed 软件套件,我们可以将部分 AI 模型迁移至 SSD 存储中。这样做的主要好处是能在固定的 GPU 显存容量下,支持运行更复杂的模型或多个模型。例如,我们成功演示了运行一个 700 亿参数模型(通常需占用约 160GB 内存),而实际峰值内存用量仅需 7GB 至 8GB。

主要发现

1. 减少 DRAM 使用量

图 1. 启用与未启用 SSD 卸载时的 DRAM 使用量对比(数值越低越好)

图 1. 启用与未启用 SSD 卸载时的 DRAM 使用量对比(数值越低越好)

将 AI 数据从内存卸载到 SSD 的核心价值显而易见:可大幅降低内存需求。我们使用 VectorDBBench(一款开源数据库基准测试工具),对三个规模递增的数据集(从 100 万矢量到 1 亿矢量)进行了性能影响评估。

优化效果的显著程度与数据库规模呈正相关。换句话说,处理的数据越多,内存节省效益就越显著。在最大规模数据集上,我们观察到 DRAM 使用量减少了 191GB,降幅达 57%。按照当前市场价格计算,此举可显著降低成本。

2. 提高查询速度

图 2. 启用与未启用 SSD 卸载时的每秒查询次数对比(数值越高性能越优)

图 2. 启用与未启用 SSD 卸载时的每秒查询次数对比(数值越高性能越优)

通过将数据从内存迁移至 SSD,我们观察到每秒查询次数 (QPS) 的性能有所提升:中等规模数据集性能最高提升 70%,最大规模数据集提升 50%。换句话说,该方案不仅能以更低内存需求完成推理,还能实现更快的处理速度。

这看似有违直觉——从存储设备而非内存读取数据,竟能提升性能? 但我们经过三重验证确认数据无误。在默认参数配置下,DiskANN 的 QPS 表现优于 HNSW(依赖传统内存方案)。采用充分预处理索引算法(如 DiskANN 所用的 Vamana),可通过高效组织矢量数据在 SSD 中的存储结构,显著加速相似性搜索(关于索引的内容稍后详述)。

需要说明的是,在 Solidigm 的测试中,HNSW 的性能虽可通过调整参数提升,但需以更高的内存消耗为代价。

3. 权衡:构建时间增加

图 3. 启用与未启用 SSD 卸载时的索引构建时间对比(数值越低越好)

图 3. 启用与未启用 SSD 卸载时的索引构建时间对比(数值越低越好)

常言道,“天下没有免费的午餐”,这一原则在此同样适用。采用卸载方案构建 RAG 索引的初期时间成本将增加 30% 至 60%。

当然,前期投入更高成本的回报在于:一旦系统部署完成,即可获得持续更优的运行性能。

对于某些应用场景而言,这种取舍可能成为关键制约因素。然而对多数应用场景而言,其带来的内存占用降低与 QPS 性能提升优势,远比索引构建时间增加重要。毕竟相较于模型实际生成洞察的高频使用场景,索引构建只是低频操作。

4. 高召回率

图 4. 启用与未启用 SSD 卸载时的召回率对比(数值越高性能越优)

图 4. 启用与未启用 SSD 卸载时的召回率对比(数值越高性能越优)

最后需要说明的是召回率——即模型输出的准确性表现。我们观察到,传统内存方案与 SSD 卸载方案的召回率表现无显著差异,两者均接近 100%。换句话说,卸载数据不会影响输出质量。

结论

实测数据确证如此。我们认为,该方案为希望低成本扩展推理数据规模的企业提供了显著价值。RAG 数据卸载意味着能以更低成本扩展至更大规模数据集;而模型权重卸载则使企业能更轻松地将解决方案部署至传统硬件或边缘设备——这些场景通常面临更严苛的 GPU 显存限制。

但您无需仅凭我们的一面之词做出决定。请访问 GitHub repo,获取完整复现本结论所需的所有资源。您还可以在白皮书《具有 SSD 卸载功能的高性能 TCO 优化 RAG》(High-Performance TCO-Optimized RAG With SSD Offloading) 中深入了解数据和方法。

关于作者

Ace Stryker 是 Solidigm 的市场开发总监,他主要负责公司数据中心存储解决方案产品组合中的各种新应用。

注

本文最初发表于《数据中心前沿》(Data Center Frontier)。

请参阅白皮书《具有 SSD 卸载功能的高性能 TCO 优化 RAG》(High-Performance TCO-Optimized RAG With SSD Offloading) 获取本文引用的数据与图表来源。

本文中的任何内容均无意作出任何明示或默示的担保,包括但不限于关于适销性、适合特定目的及不侵权的默示保证,或在履行合同、交易过程或贸易惯例中产生的任何担保。

本文所述产品可能存在设计缺陷或错误(已在勘误表中注明),可能会使产品偏离已经发布的技术规范。可应要求提供最新特征勘误表。

Solidigm 不对第三方数据承担任何控制或审计的责任。您应参考其他信息来源以评估准确性。

请在下单之前联系您的 Solidigm 代表或经销商以获取最新规格。

SOLIDIGM 及 Solidigm“S”徽标均为 SK hynix NAND Product Solutions Corp.(以 Solidigm 名义开展业务)的商标,已在美国、中华人民共和国、日本、新加坡、欧盟、英国、墨西哥及其他国家注册。